GPTBotによるクロールを防ぐには、robots.txtファイルに以下の記述を追加してください。

User-agent: GPTBot

Disallow: /GPTBotについて

GPTBotはOpenAIが使用するWebクローラです。

クローラとはインターネット上のWebページをクロール(巡回)してデータを収集するツールです。

例えばGoogleは独自のクローラを活用し、検索結果の順位に反映させるため最新のページ情報を集めています。

利用用途

GPTBotを開発したOpenAIはChatGPTも開発しています。

大規模言語モデルであるChatGPTの学習に、GPTBotが集めたwebページの情報が活用されます。

ただし以下のような内容はクロールから除外します。

- ペイウォールによってアクセスが制限されるコンテンツ:

新聞や雑誌のオンライン版など有料コンテンツ - 個人を特定できる情報(PII)を収集していると知られているサイト:

氏名、住所、電話番号、電子メールアドレスなど - OpenAIのポリシーに違反するテキストを含むサイト:

違法なコンテンツ、危険な物質、ヘイトスピーチ、成人向けコンテンツなど

Web pages crawled with the GPTBot user agent may potentially be used to improve future models and are filtered to remove sources that require paywall access, are known to gather personally identifiable information (PII), or have text that violates our policies. Allowing GPTBot to access your site can help AI models become more accurate and improve their general capabilities and safety. Below, we also share how to disallow GPTBot from accessing your site.

GPTBot公式ドキュメント

ブログへの影響

クローラが収集するデータはブログ記事も例外ではありません。

つまり書いた記事がAIの学習に使われます。

OpenAIの言い方をすると、AIの性能向上や安全性向上に寄与できます。

クロールの制限方法

robots.txtファイルを変更することで特定の場所へのアクセスを許可したり禁止したり指示できます。

robots.txt ファイルは、クローラにサイトのどのファイルへのアクセスを許可するかを管理できるファイルです。

その手順を紹介します。

既存の設定を確認する

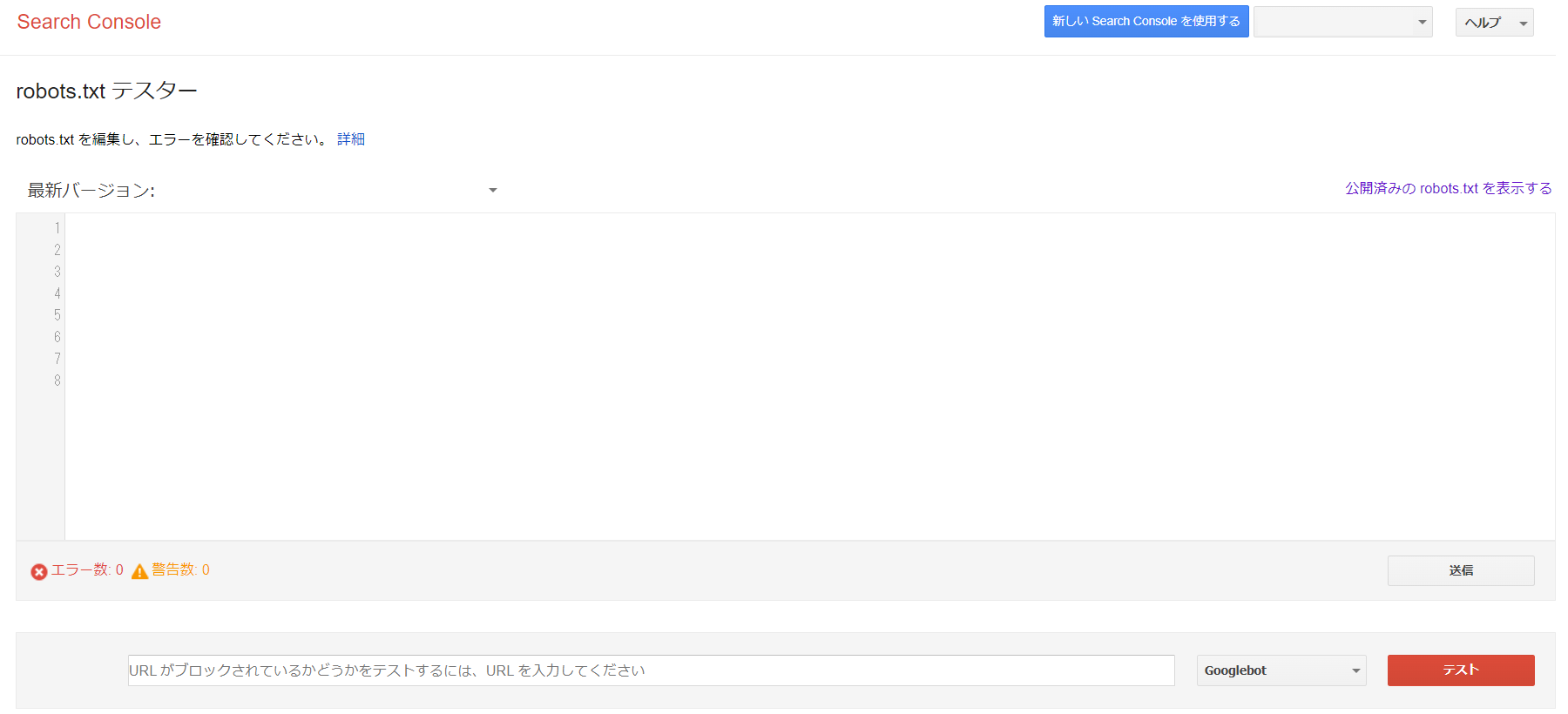

まず現在のrobots.txtファイルに何が記載されているかを確認します。

ブラウザで”exanple.com/robots.txt”のように自身のドメインの後ろに/robots.txt をつけると表示できます。

もしくはSearch Consoleにある robots.txt テスターのページにて「公開済みの robots.txt を表示する」を選択します。

例えば以下のような内容が記載されています。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://exanple.com/sitemap.xmlrobots.txtファイルを作る

テキストエディタを使ってrobots.txtファイルを新たに作成します。

サイト全体に対してクロールを制限する場合、既存内容へ以下のような最後の2行を追記します。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://exanple.com/sitemap.xml

User-agent: GPTBot

Disallow: /もし一部分だけクロールを制限する場合、許可するページはAllowに、許可しないページはDisallowに記載してください。

User-agent: GPTBot

Disallow: /

Allow: /public/この記載では、public 配下のページにのみクロールされます。

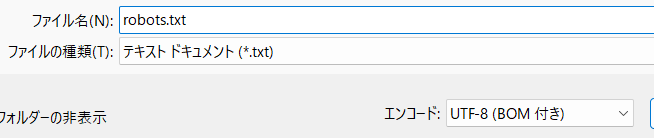

最後に、テキストファイルはUTF-8(BOM付き)で保存します。

ファイル名にはrobotsとsが付きますので注意してください。

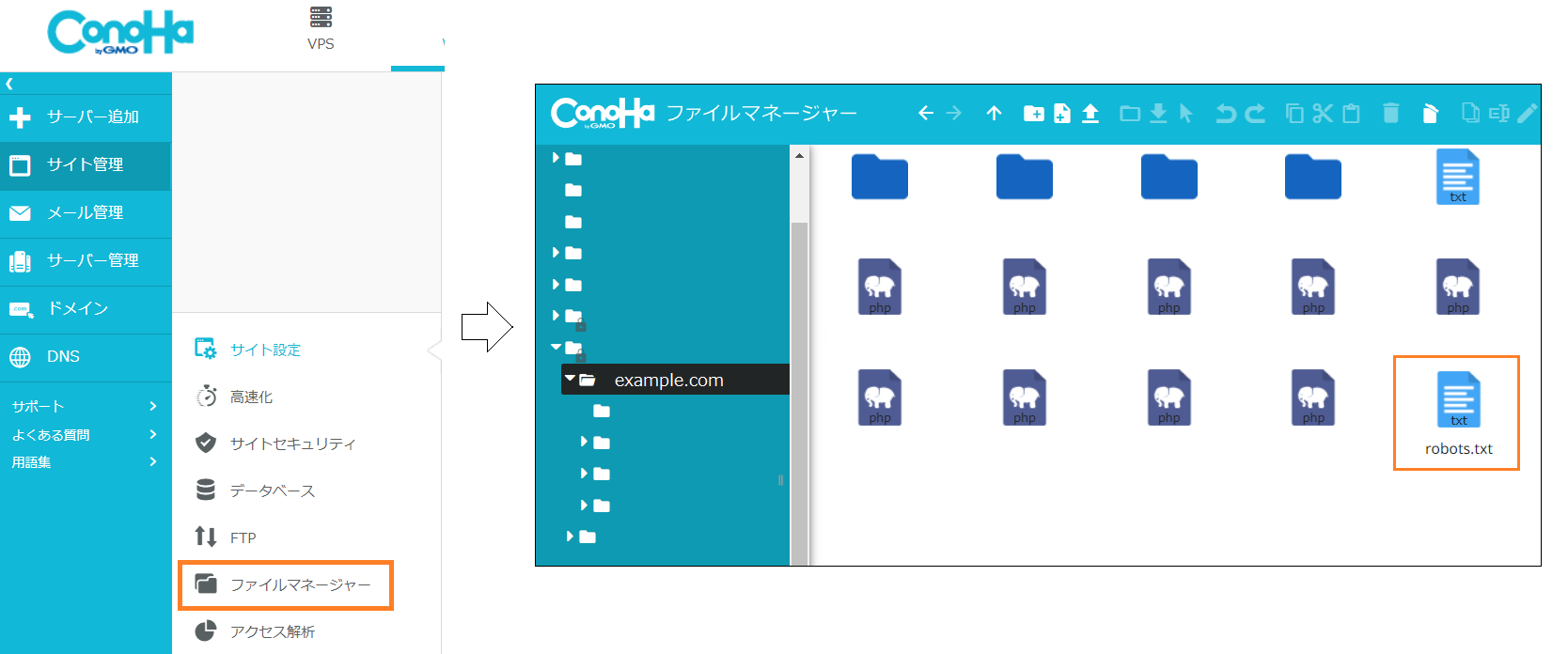

サーバーに反映させる

作成したrobots.txtファイルを自身のドメイン配下に保存します。

wp-adminフォルダやwp-active.phpファイル、wp-login.phpファイルなどが置いてある場所です。

レンタルサーバーにConoHaを使っている場合は「サイト管理」の中にある「ファイルマネージャー」を使います。

間違いが無いか確認する

設定を間違えるとGoogleからのクロールも制限して検索結果に表れなくなってしまいます。

そのためSearch Consoleにある robots.txt テスターで確認します。

「送信ボタン」から「Google に更新をリクエスト」を選択することでrobots.txtファイルの更新を知らせます。

その後、GoogleBotを選択し、テストボタンを押して「許可済み」と出れば問題ありません。

IPアドレスでの制限

余談ですが、OpenAIはGPTBotなどからの接続が来るIPアドレスの範囲を公開しています。

IPアドレスを用いた制限もかけることはできます。

オススメ書籍

・「ゆる副業」のはじめかた

ブログの開設から基本的な考え方まで学ぶことができます。

まずこの書籍を読みながらブログを始めることをオススメします。

-

-

「ゆる副業」のはじめかた アフィリエイトブログ

www.amazon.co.jp

・ブログライティングの教科書

ブログに特化した文章の書き方を基礎から学べます。

小手先のテクニック本が多い中、この書籍は文章に焦点を当てており非常に勉強になります。

-

-

ブログ歴17年のプロが教える売れる文章術 ブログライティングの教科書

www.amazon.co.jp

・生成AI導入の教科書

生成AIをどのようにビジネスで活用するか?に焦点を当てて解説された書籍です。

今後AIは作る時代から使う時代へ移っていきます。

技術的に理解しつつも、どのようにビジネスへ利用して効果を上げるか考えるのにオススメです。

-

-

生成AI導入の教科書

www.amazon.co.jp